به عنوان یک سئوکار قطعا تا کنون نام فایل robots.txt را شنیده اید و با آن کار کرده اید. اما اگر هنوز به صورت دقیق و علمی نمی دانید robots.txt چیست؟ و نحوه ی ساخت آن در سایت های وردپرسی و غیر وردپرسی چگونه است با جت سئو همراه شوید. در این مقاله قصد داریم به کاربرد فایل robots.txt و نحوه ساخت آن و همچنین دستورات مهم و کاربردی موجود در این سایت بپردازیم.

همان طور که از نام robots.txt برمیآید، این فایل برای رباتها ساخته میشود و سطح دسترسی رباتها به فایلهای موجود در هاست را تعیین و محدود میکند. این کار برای جلوگیری از صدمه به سایت، افشا شدن فایلهای محرمانه و همچنین بهبود رتبه سایت در صفحات جستجو ضروری است. اهمیت ساخت فایل robots.txt به قدری است که باید برای جلوگیری از دسترسی رباتهای مخرب به اطلاعات محرمانه سایت، بلافاصله بعد از معرفی سایت به موتورهای جستجو، اقدام به ساخت آن نمایید.

در واقع رباتها چند نوعاند:

- انواعی از آن برای موتورهای جستجو کار میکنند. کار این رباتها (که به آنها خزنده یا اسپایدر هم میگویند) این است که صفحات سایت را بررسی کنند و تغییرات آن را به اطلاع موتورهای جستجو برسانند. صفحاتی که توسط رباتها بررسی میشوند در موتورهای جستجو به نمایش درخواهند آمد.

- انواع دیگری ربات نیز در فضای وب وجود دارند که با قصد خرابکاری در سایتهای دیگر به وجود آمدهاند. این رباتها نباید به فایلهای محرمانه شما دسترسی پیدا کنند. در غیر این صورت میتوانند به سایتتان صدمات جدی وارد نمایند.

کاربرد فایل robots.txt در سئو

همانطور که گفته شد، رباتهای موتورهای جستجو به طور پیش فرض تمام صفحات و فایلهای وبسایت شما را میخزند و اطلاعات آن را در اختیار موتورهای جستجو قرار میدهند. موتورهای جستجو نیز اطلاعات به دست آمده را در صفحات نتایج سرچ (SERP) نمایش میدهند. خب این چیز خوبی است؛ پس چرا باید برخی فایلها و صفحات سایتمان را از دید رباتهای گوگل و سایر موتورهای جستجو مخفی نگهداریم؟

حفظ امنیت سایت

مهمترین دلیل ساخت فایل robots.txt حفظ امنیت سایت است. فرض کنید موتورهای جستجو به فایلهای محرمانه دسترسی داشته باشند و آنها را روی صفحات SERP نمایش دهند. به این ترتیب این اطلاعات برای همه کاربران اینترنت قابل دسترسی خواهد بود. همچنین سارقین و هکرهای اطلاعات عموما با ساخت برنامهها و روباتهای مخرب اقدام به نفوذ در سایتهای اینترنتی میکنند. این فایل با مسدود کردن دسترسی روباتهای اینترنتی به منابع و سورسهای مهم وبسایت، باعث ارتقا امنیت وبسایت میشود. البته دقت کنید که بیان کردیم: "ارتقا امنیت"، نه ایجاد امنیت کامل!

بهبود رتبه سایت

همانطور که میدانید، رتبه سایت حاصل جمع رتبه تک تک صفحات سایت است. اما برخی از صفحات مانند صفحه ورود به سایت فقط مخصوص شماست و یا نیازی نیست که بازدید بالایی داشته باشند. از آنجا که بازدید این صفحه پایین است، میتواند روی رتبه کل سایت شما اثر بگذارد.

بستن دسترسی عموم به صفحات خاص

ممکن است صفحاتی را روی سایت خود ایجاد کرده باشید که فقط برای افراد خاصی کاربرد داشته باشد؛ مثلاً فرض کنید یک صفحه مخصوص عقد قرارداد با کسانی که قصد همکاری با شما را دارند ایجاد کردهاید و نمیخواهید این صفحه در نتایج جستجوی گوگل نمایش داده شود.

در این صورت میتوانید، آدرس این صفحه را در فایل robots.txt قرار دهید و به این ترتیب به موتورهای جستجو بفهمانید که این صفحات را بررسی نکرده و در فهرست SERP قرار ندهند.

مثال دیگر، صفحاتی است که حاوی محتوای تحت قانون کپیرایت هستند و انتشار آنها طبق قانون موتورهای جستجو ممنوع است. اگر رباتهای موتورهای جستجو این صفحات را بررسی کنند، ممکن است نتیجه آن برای سایتتان خوشایند نباشد.

افزایش سرعت سایت

البته این مسئله فقط برای وبسایتهایی که روزانه کاربرهای خیلی زیادی دارند صادق است. فرض کنید وبسایت شما در روز هزاران بازدید داشته باشد. در کنار آن، هزاران ربات نیز هر روز سایت را میخزند و بررسی میکنند که این، خود باعث افت سرعت سایت خواهد شد. بنابراین مدیر سایتهایی که بازدید روزانه آنها خیلی زیاد است، برای افزایش سرعت سایتشان، دسترسی رباتها را به صفحاتی که برای سئو و رتبه سایت اهمیت زیادی ندارند محدود میکنند تا به این ترتیب فقط صفحات مهمشان توسط رباتها بررسیشده و دچار افت سرعت نشوند. توجه داشته باشید که خزیدن رباتها در سایتهایی که بازدید روزانه زیادی ندارند، تأثیر چندانی بر روی سرعت سایت ندارد. لذا این سایتها نباید اقدام به محدود کردن دسترسی ربات گوگل با هدف افزایش سرعت سایتشان نمایند.

دستورات فایل robots.txt و کاربرد آنها

بعد از اینکه فایل robots.txt را ساختیم (نحوه ساخت فایل robots.txt در ادامه آموزش داده شده است) باید دستورات لازم را در آن وارد کنیم. به عبارت دیگر باید مشخص کنیم که کدام رباتها به چه فایلهایی اجازه دسترسی ندارند.

دستور user-agent

باید در اولین خطی که در فایل robots.txt مینویسیم مشخص کنیم که این دستور برای کدام رباتهاست.

در مقابل دستور user-agent: نام ربات نوشته میشود. مثلاً اگر شما قصد دارید دستور را برای ربات گوگل صادر کنید باید در فایل robots.txt دستور زیر را بنویسید:

User-agent: Googlebot

همچنین تعیین دستوری برای رباتهایی که تصاویر را برای گوگل رصد میکنند به صورت زیر است:

User-agent: Googlebot-image

چنانچه بخواهید دستوری برای کلیه رباتها صادر کنید، باید در مقابل عبارت user-agent: علامت ستاره بگذارید. مانند زیر:

User-agent: *

دستور disallow

عبارت disallow به معنی اجازه ندادن است. بنابراین شما هر چیزی که در مقابل این دستور بنویسید، یعنی رباتها اجازه دسترسی به آن را ندارند. بنابراین شما میتوانید در مقابل این دستور نام فایلهایی را که قصد دارید برای رباتها ببندید بنویسید.

مسدود کردن دسترسی رباتها به یک پوشه یا فایل خاص

توجه داشته باشید که در هر دستور فقط نام یک فایل نوشته شود. به مثال زیر نگاه کنید:

User-agent: *

Disallow: /admin/

Disallow: /files/tutorial.mp4

در دستورات بالا، اجازه دسترسی به پوشه admin و فایل tutorial برای کلیه رباتها مسدود شده است.

همانطور که مشاهده میکنید، در دستور خط سوم، مسیر دسترسی به فایل tutorial داده شده است. بنابراین چنانچه بخواهید اجازه دسترسی به فایل خاصی را مسدود کنید باید مسیر دسترسی به آن را در مقابل دستور disallow بنویسید. در انتهای مسیر نیز نام خود فایل به همراه فرمت آن نوشته میشود.

اما در خط دوم دسترسی به پوشه admin به همراه کلیه محتویات داخل پوشه مسدود شده است. هنگام محدود کردن دسترسی به محتویات یک پوشه، حتماً باید در انتهای نام پوشه یک اسلش دیگر بگذارید.

مسدود کردن دسترسی ربات ها به یک فرمت خاص

چنانچه بخواهید به رباتها دستور بدهید که به یک فرمت مشخص از فایلها دسترسی پیدا نکنند، باید دستور زیر را وارد کنید:

Disallow: /*.pdf$

Disallow: /*.gif$

در دو دستور بالا، دسترسی رباتها به همه فایلهایی که با فرمتهای gif و PDF نوشتهشدهاند، محدود شده است.

فرض کنید شما در سایت خود تعداد زیادی فایل pdf دارید؛ اما قصد ندارید دسترسی آن برای عموم آزاد باشد. بنابراین، این فایلها نباید در نتایج سرچ گوگل نمایش داده شوند. در این حالت دستوری برای رباتهای گوگل (یا همه رباتها) مینویسید و به آنها میگویید که به فایلهای pdf شما کاری نداشته باشند.

مسدود کردن دسترسی رباتها به یک صفحه خاص

برای اینکه دسترسی رباتها به یک صفحه خاص را محدود کنید، آدرس آن صفحه را از آدرس دامنه اصلی به بعد در مقابل دستور disallow بنویسید.

برای مثال برای مسدود کردن دسترسی رباتها به صفحه https://example.ir/blog/page1 به صورت زیر عمل نمایید:

Disallow: /blog/page1/

دستور /:disallow

وقتی یک اسلش خالی در مقابل دستور :disallow بگذارید دسترسی به کل سایت را برای رباتها غیر مجاز کردهاید. این دستور برای زمانهایی که قصد ایجاد تغییرات اساسی در سایتتان دارید یا زمانهایی که سایتتان دچار مشکل شده و از دسترس خارج شده است میتواند مناسب باشد. به این ترتیب گوگل و موتورهای جستجوگر در زمانهایی که سایت آماده استفاده نیست، آن را نمیخزند (crawl نمیکنند) و در دسترس کاربران قرار نمیدهند. بهعلاوه افت رتبه نیز پیدا نخواهید کرد.

البته بهتر است در کنار disallow کردن کل سایت، صفحات آن را noindex نیز بکنید؛ چراکه گاهی با وجود دستور disallow، برخی صفحات همچنان در موتورهای جستجو ایندکس میشوند. اما با noindex کردن آنها دیگر خیالتان راحت خواهد بود.

بیشتر بخوانید : noindex چیست؟

دستور allow

این دستور مشخص میکند که ربات مذکور، اجازه دسترسی به فایل مشخصشده را دارد. البته همان طور که گفته شد، به صورت پیشفرض، خزندهها و رباتها تمام فایلها و صفحات سایت را بررسی میکنند، اما عدهای معتقدند برای تأکید بیشتر بر روی برخی صفحات یا فایلهای خاص باید از دستور allow استفاده کرد.

دستور allow نیز مانند دستور disallow به کار میرود:

User-agent: googlebot

Allow: /files/project.docs

دستور sitemap

در فایل robots.txt میتوانید نقشه سایت را برای رباتها تعریف کنید تا به نقشه کل سایت دسترسی داشته باشند.

برای این منظور، دستور زیر را در فایل robots.txt وارد نمایید:

Sitemap: https://www.example.ir/sitemap_index.xml

بهتر است قبل و بعد از دستور sitemap یک خط خالی بگذارید تا از بروز خطا جلوگیری شود. در ضمن این دستور نیازی به user-agent ندارد.

دستور crawl-delay

با این کد دستوری به خزندهها میگویید که بین بررسی هر صفحه از سایت شما، برای مدت زمان مشخصی صبر کنند. برای مثال به دستور زیر توجه کنید:

Crawl-delay: 10

شما با این دستور به تمام رباتهای خزنده (به جز رباتهای گوگل – این دستور بر روی رباتهای گوگل اثر ندارد) اعلام میکنید که بعد از بررسی و ایندکس کردن یک صفحه از سایتتان، 10 ثانیه صبر کنند و بعد از آن به بررسی صفحه بعدی بپردازند. دوباره 10 ثانیه تأمل و سپس صفحه بعدی. این کد برای کم شدن ترافیک سایتتان مناسب است و سرعت رفت و آمد رباتها به سایتتان را کاهش میدهد و در نتیجه سرعت سایتتان بهتر خواهد شد.

البته به این نکته هم توجه داشته باشید که با این کار، سرعت ایندکس شدن صفحات سایتتان پایین میآید. بنابراین چنانچه سایت خیلی بزرگی با تعداد زیادی صفحه دارید، تعداد صفحاتی که در روز ایندکس میشوند را نیز در نظر بگیرید تا بعداً دچار پشیمانی نشوید.

چه صفحاتی را از دید خزندههای گوگل مخفی کنیم؟

از آنجا که ما نمیخواهیم برخی فایلها مانند فایل افزونهها یا برخی صفحات مثل صفحه ورود به سایت در موتورهای جستجو به نمایش دربیاید باید با ساخت فایل robots.txt به موتورهای جستجو بگوییم که رباتهای شما اجازه دسترسی به این صفحات یا فایلها را ندارند. اما دقیقاً چه صفحاتی را باید از دید خزندههای گوگل مخفی کنیم؟ صفحاتی که نباید در نتایج جستجو به نمایش دربیایند. مثل:

فایل readme

فایل readme.html حاوی اطلاعات وردپرس شماست. اگر کسی به این اطلاعات دسترسی پیدا کند میتواند متوجه آپدیت نبودن نسخه وردپرس شما شده و با توجه به باگهایی که برای آن شناسایی شده است به سایت شما حمله کند. بنابراین حتماً برای حفظ امنیت سایت خود، دسترسی به فایل readme.html را برای رباتها محدود کنید:

User-agent: *

Disallow: /readme.html

فایل افزونهها

فایل افزونهها اطلاعات افزونهها را در بردارد. بنابراین، این فایل نیز مانند فایل readme.html نقطهای برای نفوذ و تخریب سایتتان محسوب میشود. وقتی باگهای افزونهها پیدا میشود، عدهای برنامهنویس اقدام به رفع باگ کرده و نسخه جدیدی از آن را منتشر میکنند. در مقابل عده دیگری سایتهایی که هنوز افزونه خود را به روزرسانی نکردهاند جستجو و به آنها حمله میکنند.

با بستن دسترسی رباتها به فایل افزونهها، جلوی ورود هکرها به سایت خود را بگیرید:

Disallow: /wp-content/plugins/

صفحه ورود به وردپرس

باید دسترسی به صفحه ورود به وردپرس نیز در فایل robots.txt محدود شود. برای disallow کردن صفحات wp-login.php و wp-admin به صورت زیر عمل کنید:

Disallow: /wp-login.php

نمونه فایل robots.txt

برای نوشتن دستورات allow و disallow لازم نیست هر بار یک user-agent تعریف کنیم. یک بار user-agent را تعریف کنید و در سطرهای بعدی دستورهای disallow (یا allow) را بنویسید.

چنانچه قصد دارید بعضی دستورات را برای رباتهای خاصی بنویسید، میتوانید دوباره یک user-agent دیگر نوشته و در سطرهای بعدی دستورات مخصوص به آن ربات را تعریف کنید.

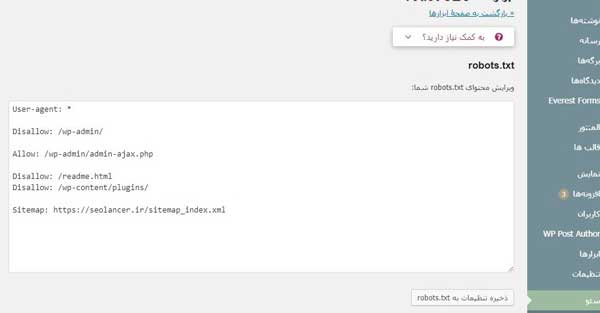

در تصویر زیر میتوانید یک نمونه فایل robots.txt را مشاهده کنید:

User-agent: *

Disallow: /readme.html

Disallow: /wp-content/plugins/

Sitemap: https://example.com/sitemap_index.xml

User-agent: googlebot-image

Disallow: /files/project.png

در دو سطر آخر مشاهده میکنید که دسترسی ربات جستجوگر تصاویر گوگل به تصویری با اسم project مسدود شده است. بنابراین تصویر مذکور در جستجوی تصاویر گوگل نمایش داده نمیشود.

مشاهده فایل robots.txt سایر سایتها

شما همچنین میتوانید با اضافه کردن /robots.txt به انتهای آدرس هر سایتی، فایل رباتس آن سایت را مشاهده نمایید.

آموزش ساخت و تنظیم فایل robots.txt

فایل robots.txt در روت اصلی هاست قرار میگیرد. قبل از اینکه اقدام به ساخت فایل robots.txt کنید، به انتهای آدرس سایتتان عبارت /robots.txt را اضافه کنید. چنانچه محتویات صحیحی مشاهده کردید یعنی این فایل قبلاً ساخته شده و شما فقط باید اطلاعات آن را طبق دلخواه خود تنظیم کنید. اما چنانچه با خطای 404 مواجه شدید یعنی این فایل ساخته نشده و باید آن را بسازید.

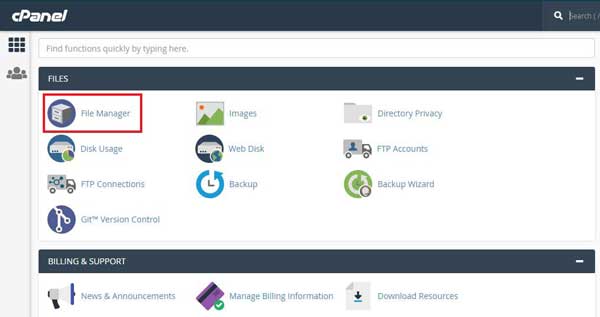

برای ساخت این فایل به کنترل پنل هاست خود بروید و طبق مراحل زیر عمل نمایید:

- file manager یا مدیریت فایل را باز کنید.

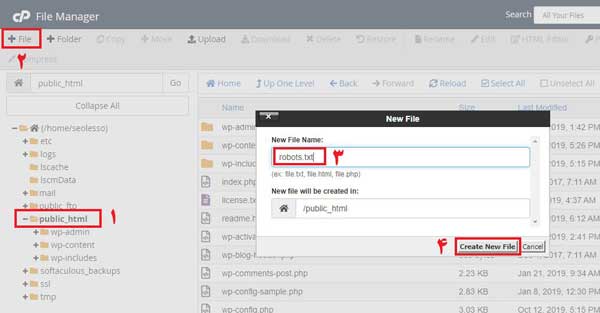

- سپس روی مسیر public_html کلیک نمایید.

- از بالای صفحه، گزینه +File یا new file را کلیک کنید و فایل robots.txt را در مسیر public_html بسازید.

توجه داشته باشید که در ساخت این فایل، کوچکی و بزرگی حروف اهمیت دارند. بنابراین نام فایل را با حروف کوچک تایپ کنید. همچنین در درج دستورات نیز، هنگام تایپ کردن نام فایلها و پوشهها، به کوچکی و بزرگی حروف نام آنها توجه داشته باشید.

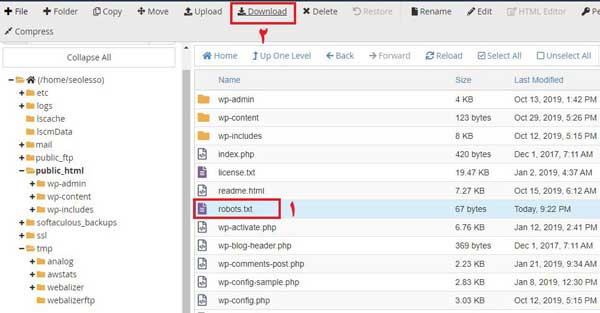

- فایل ایجادشده را بر روی کامپیوتر خود ذخیره کنید.

- سپس آن را با برنامه notepad باز کرده و تغییرات لازم را بر روی آن ایجاد کنید.

- فایل مذکور را دوباره بر رویهاست خود آپلود و جایگزین فایل قبلی نمایید.

آموزش ساخت robots.txt در وردپرس

همچنین در پیشخوان وردپرس، از طریق افزونه یائوست نیز میتوانید این فایل را ایجاد کنید.

به این منظور، بعد از نصب افزونه یائوست، در پیشخوان وردپرس، مراحل زیر را دنبال کنید:

- وارد قسمت سئو بشوید و روی گزینه ابزارها کلیک کنید. در صفحهای که باز میشود بر روی دومین لینک با نام «ویرایشگر فایل» کلیک کنید.

- در صفحه جدیدی که باز میشود، روی ایجاد پرونده robots.txt کلیک کنید.

- تغییرات لازم را اعمال کرده و سپس بر روی ذخیره کلیک کنید.

تست فایل robots.txt در وبمستر

بعد از اینکه فایل robots.txt را ساختید، باید آن را تست کرده و در صورت بدون اشکال بودن به گوگل معرفی کنید. برای این منظور از وبمستر استفاده میکنیم.

- بر روی این لینک کلیک کنید تا ابزار وبمستر برای شما باز شود. سپس سایت خود را انتخاب نمایید. البته اگر قبلاً اکانت وبمستر ایجاد نکرده باشید، میتوانید از همین صفحه آن را بسازید و سپس مراحل را ادامه دهید.

- در پایین صفحهای که باز میشود یک نوار میبینید که در مقابل آن یک دکمه قرمز رنگ با نوشته test وجود دارد. در این نوار بنویسید robots.txt و سپس بر روی دکمه تست کلیک کنید.

- اگر فایل robots.txt که ساختهاید مشکلی نداشته باشد، دکمه تست به رنگ سبز تغییر میکند. اکنون میتوانید آن را به گوگل معرفی کنید.

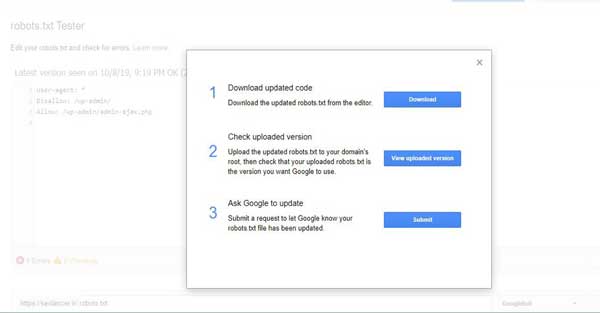

- بر روی دکمه submit کلیک کنید.

- پنجره کوچکی باز میشود که سه گزینه دارد. دو گزینه بالایی برای چک کردن دوباره فایل و گزینه پایینی برای تأیید submit است. بر روی گزینه پایینی کلیک کنید.

در این مطلب فایل robots.txt شما ساخته و تنظیم شد، سپس درستی فرایند را بررسی و در انتها نیز آن را برای گوگل تعریف کردیم. اکنون رباتها ابتدا فایل robots.txt شما را میخوانند و سپس طبق آن عمل میکنند. البته توجه داشته باشید که برخی رباتها اهمیتی به این فایل نمیدهند و حتی صفحاتی که شما دسترسی به آن را مسدود اعلام کردهاید را بررسی میکنند.

بیشتر بخوانید : open graph چیست؟

برای آنالیز سایت پیشنهاد میکنیم از جت سئو و افزونه جت سئو استفاده کنید. به کمک آن می توانید مشکلات فنی هر صفحه از سایت خود یا رقبا را به راحتی بیابید. همچنین برای مشاهده رتبه سایت خود بین رقبا هستید می توانید به صفحه مربوطه مراجعه کنید.

تو فایل روبوتس من جلوی :Disallow نوشته شده process/ یعنی چی؟

این موضوع بر اساس سیستم مدیریت محتوای سایت مشخص میشه و این سوال را بهتر است از برنامه نویس سایت خودنون بپرسید. در واقع با این کار جلوی خزش پوشه process گرفته شده