ربات گوگل، ابزار مهم و شگفت انگیزی است که برای رتبه بندی بهتر و عادلانه تر به گوگل کمک می کند. شناخت ربات گوگل به کارشناسان سئو کمک می کند درک درست تری از نحوه عملکرد گوگل داشته باشند. در ادامه این نوشتار با ربات گوگل، نحوه کار، انواع و وظایف ربات های گوگل آشنا می شوید و دید بهتری نسبت به ربات های گوگل پیدا می کنید که مطمئنا تاثیر بسیار زیادی در تصمیم گیری های آینده تان برای سئو سایت خواهد داشت.

اینکه گوگل چگونه میتواند صفحات متعدد موجود در اینترنت را بررسی کند و آنها را جزو نتایج جستجوی خود قرار دهد، سوالی است که برای بسیاری از کاربران اینترنت وجود دارد. این روزها میتوان گفت روزانه هزاران یا حتی شاید میلیونها صفحه در فضای اینترنت منتشر شده و میلیونها جستجو هم در گوگل انجام میشود. صفحاتی که به صدها زبان زنده دنیا نوشته میشوند و انواع محتواها از متن گرفته تا ویدئو و تصویر را در بردارند. به همین نسبت جستجوها در گوگل هم به زبانهای مختلف دنیا انجام شده و شامل انواع جستجوی سایت، تصویر و ویدئو میشوند.

گوگل درواقع به عنوان پلی در فضای اینترنت است که دو سوی این بازی را بهم میرساند. در یک سو کاربرانی که به دنبال اطلاعات میگردند، قرار دارند. در سوی دیگر هم سایتهایی حضور دارند که میخواهند کاربر را به سایت خود آورده و اطلاعات را به او برسانند. گوگل برای اتصال این دو طرف از رباتها استفاده میکند. رباتهایی که همواره در حال خزیدن بین صفحات وب هستند و همه چیز را زیر نظر دارند. در این مقاله از جت سئو میخواهیم با نحوه کار ربات گوگل و انواع آن آشنا شویم. تا پایان با ما همراه باشید.

ربات گوگل یا گوگل بات (Googlebot) چیست؟

قبل از اینکه بدانید ربات گوگل چیست، بهتر است ابتدا با اصطلاحات خزنده یا عنکبوت هم در گوگل آشنا شوید. جالب است بدانید ربات گوگل، خزنده گوگل یا عنکبوت گوگل همه اصطلاحاتی هستند که برای یک چیز به کار میروند؛ برنامههای گوگل که توسط آنها صفحات مختلف وب رصد میشوند. شاید برای شما هم این سوال پیش آمده باشد که گوگل چگونه میتواند این حجم از صفحات مختلف را در سایتهای اینترنتی به همه زبانهای دنیا بررسی کند و آنها را در نتایج جستجو نمایش دهد.

مطمئنا گوگل این کار را به صورت دستی توسط کارمندانش انجام نمیدهد! بلکه رباتهایی برای این کار تدارک دیده که به صورت خودکار در هر لحظه صفحات اینترنتی را زیر نظر دارند. هر ربات گوگل همواره در حال خزش در صفحات سایتها است. این رباتها با استفاده از لینکهایی که سایتها به یکدیگر میدهند، صفحات جدید را پیدا کرده و آنها را خزش میکند. همچنین محتواهای بهروزشده را هم رصد میکند. سپس در صورتی که محتواهای جدید، شرایط مورد تایید گوگل را داشته باشند، آنها را به ایندکس اضافه میکند. البته باید در نظر گرفت که ربات های گوگل برای هر سایتی یک بودجه خزش در نظر می گیرد و این که چند وقت یک بار به سایت شما سر بزند بستگی به عوامل زیادی دارد.

لازم به توضیح اضافی نیست که ایندکس در واقع مغز گوگل است، همان جایی است که منبع همه اطلاعات و دانش گوگل بوده و از آن برای انتقال اطلاعات مورد نیاز به کاربران استفاده میشود. از آنجا که عملکرد گوگل بیشتر از هر چیزی به مغز آن وابسته است، کارکرد ربات گوگل برای آن اهمیت ویژهای دارد. به همین دلیل به طور مرتب این رباتها را بهروزرسانی میکند. اجرای برنامه ربات گوگل توسط صدها کامپیوتر انجام میشود. این کامپیوترها ربات گوگل را به گوشه و کنار اینترنت میفرستند تا در صفحات سایتها بگردند و تغییرات آنها را رصد کنند. همچنین صفحات جدید را پیدا کرده و محتوای آنها را بررسی کنند و چنانچه محتوایی را مناسب تشخیص دادند، به ایندکس گوگل اضافه کنند. البته رباتهای گوگل برای این کار دستورالعملهایی دارد که بر اساس آنها کیفیت هر صفحه را سنجیده و درمورد آن تصمیمگیری میکند.

ربات گوگل چگونه کار میکند؟

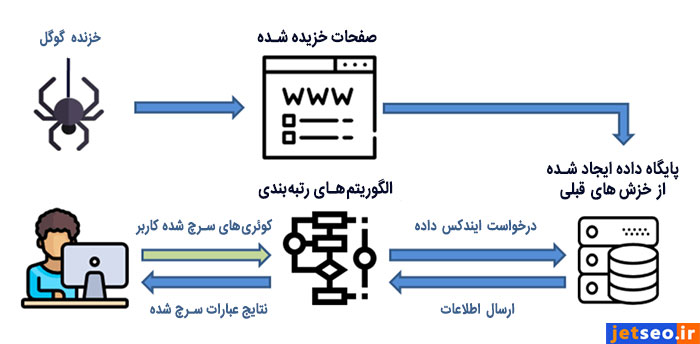

رباتهای گوگل برای خزش در سایتها از اطلاعات sitemap و همچنین پایگاه دادهای که در خزشهای قبلی ایجاد کرده، استفاده میکنند. در واقع ربات از این اطلاعات استفاده میکند تا تشخیص دهد به چه سمتی حرکت کرده و کدام صفحات را خزش کند. علاوه بر این الگوریتمها هم به کمک ربات گوگل میآیند تا تصمیم درست را بگیرد. الگوریتمها مشخص میکنند کدام سایتها خزش شوند، کدام در اولویت بالاتری قرار گیرند و کدام یک ایندکس شوند.

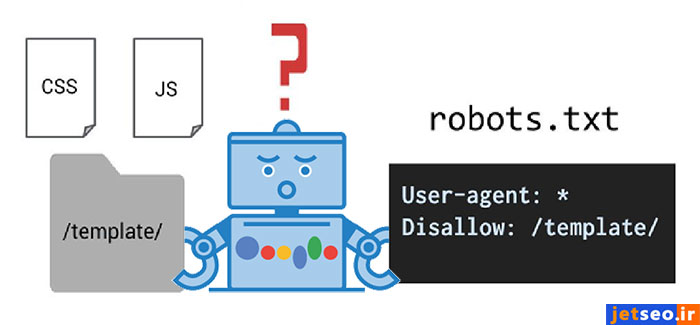

نحوه انجام کار ربات گوگل بدین صورت است که در ابتدا با استفاده از سایت مپ که مدیر سایت ساخته، لیستی از صفحات و لینکهای یک سایت را فهرست کرده و شروع به خزش در صفحات میکند. در این حین اگر صفحه یا لینک جدیدی پیدا کند، آن را به فهرست خود برای خزشهای بعدی اضافه میکند. همچنین اگر بروزرسانی در صفحات مشاهده کند یا متوجه اصلاح لینکهای شکسته سایت شود، آنها را به لیست بهروزرسانیها اضافه میکند. در نهایت این اطلاعات جمعآوری شده برای بهروزرسانی ایندکس گوگل استفاده میشوند. ایندکس گوگل بر اساس محدودیتهایی که مدیر هر سایت در فایل robots.txt تعیین کرده، شکل میگیرد.

در صورتی که به عنوان مدیر یک سایت یا مدیر سئو نمیخواهید برخی از صفحات سایتتان در نتایج جستجوی گوگل ظاهر شوند، باید آنها را در فایل robots.txt به رباتهای گوگل گوشزد کنید. همچنین در صورتی که نمیخواهید برخی لینکها در صفحات سایت شما توسط ربات گوگل خزش شوند، باید برچسب نوفالو برای آنها در نظر بگیرید. این برچسب به صورت "rel="nofollow به لینکها افزوده میشود. وقتی ربات گوگل این برچسب را میبیند از دنبال کردن لینک مربوطه خودداری میکند.

جالب است بدانید در کنفرانس SearchLove 2011، جاش جیاردینو فاش کرد که ربات گوگل در واقع همان مرورگر کروم است. این بدین معنا است که ربات گوگل تنها به رصد متنهای صفحات بسنده نمیکند، بلکه همه اسکریپتها و ویژگیهای بصری صفحه را هم اجرا میکند و نتیجه آن را در نظر میگیرد، درست همانطور که مرورگر گوگل کروم این کار را انجام میدهد. در واقع نکتهای که در این حرف نهفته، این است که ربات گوگل صفحات وب را همانطور میبیند که کاربران میبینند و به همین دلیل نکات زیادی در گوشه و کنار هر صفحه توسط ربات گوگل بررسی میشود.

برای اینکه بدانید رباتهای گوگل هر چند وقت یک بار سایت شما را خزش میکنند، باید به سراغ بخش Crawl سرچ کنسول بروید. اما اگر واقعا میخواهید اقدامات تخصصی انجام دهید تا سایت خود را برای ربات گوگل بهینهسازی کنید، میتوانید از ابزار Kibana یا SEO Log File Analyser استفاده کنید. گوگل معمولا لیست آیپیهای مورد استفاده توسط رباتهای گوگل را منتشر نمیکند زیرا این آدرسها به طور مرتب تغییر میکنند.

با این حال میتوانید از روش آیپی معکوس کمک بگیرید و بررسی کنید که آیا آیپیهایی که به سایت شما وارد شدهاند، جزو آیپیهای ربات گوگل بودهاند یا خیر. همچنین مهمترین ابزاری که میتوانید برای بررسی قابلیت خزش سایتتان استفاده کنید، سرچ کنسول گوگل است. این ابزار سئو به شما کمک میکند سایت خود را از زاویه دید ربات گوگل ببینید. درواقع این یار همیشگی سئوکارها لیستی از خطاهای خزش سایت را به شما نشان میدهد.

همچنین میتوانید با استفاده از آن از ربات گوگل بخواهید سایتتان را خزش کند. همچنین برای اینکه سایت شما زودتر توسط رباتهای گوگل خزش شود، میتوانید برخی اقدامات فنی را برای بهینهسازی آن انجام دهید. چنانچه سایت شما مشکلاتی در زمینه خزش توسط ربات گوگل دارد، بهتر است خطاهای آن را برطرف کنید. چراکه اگر سایتتان خزش نشود، هیچ امکانی برای حضور در بین نتایج جستجوی گوگل نخواهید داشت.

مقاله انکر تکست چیست را در جت سئو بخوانید

انواع ربات گوگل و وظایف آن ها

گوگل از رباتهای مختلفی برای رصد فضای وب استفاده میکند که هرکدام وظیفه مشخصی بر عهده دارند. مثلا AdSense و AdsBot کیفیت تبلیغات را بررسی میکنند و Mobile Apps Android به بررسی برنامههای اندرویدی میپردازد. در این بین مهمترین انواع ربات گوگل موارد زیر هستند:

Googlebot desktop

این ربات کار خزش و ایندکس کردن نسخه دسکتاپ صفحات وب را انجام میدهد.

Googlebot mobile

این ربات کار خزش و ایندکس کردن نسخه موبایل صفحات وب را انجام میدهد.

Googlebot Video

این ربات کار خزش و ایندکس ویدئوها را انجام میدهد.

Googlebot Images

این ربات کار خزش و ایندکس تصاویر را انجام میدهد.

Googlebot News

این ربات کار خزش و ایندکس سایتهای خبری را انجام میدهد.

Googlebot favicon

این ربات گوگل وظیفه تشخیص فاوآیکون سایت ها را برعهده دارد. پیشنهاد می کنیم مقاله فاو آیکون چیست؟ را در جت سئو بخوانید.

جمعبندی

رباتهای گوگل برنامههایی هستند که توسط گوگل برای بررسی و ایندکس صفحات وب استفاده میشوند. این رباتها با کمک اطلاعات خزش قبلی خود و sitemap هر وبسایت، به گشتن در صفحات سایتها میپردازد و آنهایی را که مناسب میداند، جدا میکند. صفحات جدا شده در ایندکس گوگل قرار میگیرند و کمکم بین نتایج جستجوی گوگل نمایش داده میشوند. در واقع وظایف اصلی رباتهای گوگل، خزش و ایندکس سایتها است.

مطالب مهمی در حوزه سئو :

دلیل اینکه برخی مواقع دسترسی صفحات را میبندیم اما گوگل آنها را ایندکس میکند چیست؟

در فایل روبات صرفا دسترسی خزش را میتوانیم محدود کنیم و این موضوع از ایندکس شدن صفحه جلوگیری نمیکند، اگر میخواهید صفحات را از ایندکس خارج کنید باید از متا تگ robots استفاده کنید و مقدار آن را noindex قرار دهید.

با چه تنظیماتی به googlebot های گوگل بگیم که صفحاتی که به 404 ارجاع میده رو ایندکس نکنه؟

در صورتیکه صفحات 404 ساختار استاندارد داشته باشند و 404 https response به درستی not found برگرداند، ربات های گوگل این صفحات را ایندکس(index) نخواهند کرد.

چه راه حل هایی وجود دارد که بات های گوگل بیشتر به سایت ما سر بزنند؟

با افزایش سرعت سایت، به روز رسانی های مداوم محتوای صفحات و و افزایش تعداد بک لینک می توانید نرخ خزش ربات های گوگل را به سایت خود افزایش دهید.

سلام اگر یک صفحه در فایل robots.txt بسته شده باشد، آیا توسط ربات گوگل کراول می شود؟

سلام فایل robots.txt فقط جلوی ایندکس شدن صفحات را می گیرد و صفحاتی که توسط این فایل Disallow شده باشند هم کراول می شوند.

وقت بخیر آیا آنچه که در نسخه کش شده نشون داده میشه همون چیزی هست که گوگل در سایت ما دیده؟

به طور کلی بله. اما دقت داشته باشید که گاها بعضی المان ها در نسخه کش شده دیده نمی شوند که دلیل این موضوع کش نشدن فایل های CSS مربوطه می تواند باشد. این به این معنی نیست که گوگل این المان هارا ندیده است.

برای اینکه مطمئن بشیم گوگل بات به ساب دامین تست دسترسی نداره چه کاری انجام بدیم؟

می توانید از Password Protection استفاده کنید.

سلام نحوه برخورد ربات های گوگل با صفحات 404 چجوریه؟

سلام هنگامی که ربات های گوگل با صفحات 404 برخورد می کنند آن ها را از ایندکس خارج می کنند و تمام لینک های داخلی و بک لینک های این صفحات بی ارزش می شوند.

عرض ارادت دارم. ببخشید چرا گوگل صفحات سایت من رو ایندکس نمیکنه؟ هر چقدر درخواست میدم تو سرچ کنسول ایندکس نمیشه.

با سلام دلایل زیادی می تواند داشته باشد: از کم بودن کراول باجت گرفته تا کیفیت پائین محتوای سایت شما.

برای اینکه ربات های گوگل بیشتر به سایت شما سر بزنن و سرعت ایندکس مطالبتون بیشتر بشه میتونید از API گوگل برای ایندکسینگ استفاده کنید.

وقتی یک صفحه دیس الاو میشه ممکنه گوگل همچنان اون صفحه رو کراول کنه؟ چون تعدادی از صفحات سایتم علی رغم دیس الاو شدن ایندکس شدن.

خیر. گوگل به هیچ وجه صفحه ای که دیس الاو شده باشد را کراول نمی کند. با این حال ممکن است در شرایط خاصی صفحاتی که دیس الاو شده اند بدون کراول شدن ایندکس شوند.

گوگل بات های دیگه ای هم وجود دارن. مثل گوگل بات favicon که وظیفه تشخیص فاوآیکون سایت هارو برعهده داره. بهتر بود به اینها هم اشاره می کردید.

ممنون از نکته ای که فرمودید. در آینده نزدیک این توضیحات هم به این صفحه اضافه خواهند شد.